分类

商品

- 商品

- 店铺

- 资讯

温馨提示:新书预定,需单独下单,和现货书籍分开购买!

热门新书预定抢先购,预计2023年3月31日到货,到货后会立即发货,请亲们耐心等候,着急的亲慎拍,给您带来不便很抱歉!注意:预定图书请与现货图书分开下单!谢谢

预定期间退款请联系在线客服,退款原因请选择为:不想要了,谢谢您的支持和理解~祝您生活愉快~!

预定商品请单独下单,到货后将快速为您发出。若您将预定商品与其他商品一并购买,则该订单默认在预定商品到货后发出,拍下即视为认可,谢谢您的支持。

第 一部分 开始使用BERT

第 1 章 Transformer 概览 2

1.1 Transformer 简介 2

1.2 理解编码器 3

1.2.1 自注意力机制 5

1.2.2 多头注意力层 14

1.2.3 通过位置编码来学习位置 16

1.2.4 前馈网络层 19

1.2.5 叠加和归一组件 19

1.2.6 编码器总览 20

1.3 理解解码器 21

1.3.1 带掩码的多头注意力层 25

1.3.2 多头注意力层 30

1.3.3 前馈网络层 34

1.3.4 叠加和归一组件 34

1.3.5 线性层和softmax 层 35

1.3.6 解码器总览 36

1.4 整合编码器和解码器 38

1.5 训练Transformer 39

1.6 小结 39

1.7 习题 40

1.8 深入阅读 40

第 2章 了解BERT 模型 41

2.1 BERT 的基本理念 41

2.2 BERT 的工作原理 43

2.3 BERT 的配置 45

2.3.1 BERT-base 46

2.3.2 BERT-large 46

2.3.3 BERT 的其他配置 47

2.4 BERT 模型预训练 48

2.4.1 输入数据 49

2.4.2 预训练策略 53

2.4.3 预训练过程 61

2.5 子词词元化算法 63

2.5.1 字节对编码 64

2.5.2 字节级字节对编码 69

2.5.3 WordPiece 69

2.6 小结 71

2.7 习题 72

2.8 深入阅读 72

第3章 BERT实战 73

3.1 预训练的BERT模型 73

3.2 从预训练的BERT模型中提取嵌入 74

3.2.1 Hugging Face的Transformers 库 77

3.2.2 BERT 嵌入的生成 77

3.3 从BERT 的所有编码器层中提取嵌入 81

3.4 针对下游任务进行微调 .85

3.4.1 文本分类任务 86

3.4.2 自然语言推理任务 91

3.4.3 问答任务 93

3.4.4 命名实体识别任务 97

3.5 小结 98

3.6 习题 99

3.7 深入阅读 99

第二部分 探索BERT 变体

第4章 BERT 变体(上):ALBERT、RoBERTa、ELECTRA和SpanBERT 102

4.1 BERT 的精简版ALBERT 103

4.1.1 跨层参数共享 103

4.1.2 嵌入层参数因子分解 104

4.1.3 训练ALBERT 模型 105

4.1.4 对比ALBERT与BERT 106

4.2 从ALBERT 中提取嵌入 107

4.3 了解RoBERTa 108

4.3.1 使用动态掩码而不是静态掩码 108

4.3.2 移除下句预测任务 110

4.3.3 用更多的数据集进行训练 111

4.3.4 以大批量的方式进行训练 111

4.3.5 使用字节级字节对编码作为子词词元化算法 111

4.4 了解ELECTRA 114

4.4.1 了解替换标记检测任务 114

4.4.2 ELECTRA 的生成器和判别器 117

4.4.3 训练ELECTRA 模型 120

4.4.4 高效的训练方法 121

4.5 用SpanBERT 预测文本段 122

4.5.1 了解SpanBERT 的架构 122

4.5.2 深入了解SpanBERT 124

4.5.3 将预训练的SpanBERT用于问答任务 125

4.6 小结 126

4.7 习题 127

4.8 深入阅读 127

第5章 BERT 变体(下):基于知识蒸馏 128

5.1 知识蒸馏简介 129

5.2 DistilBERT 模型——BERT模型的知识蒸馏版本 134

5.2.1 教师 学生架构 134

5.2.2 训练学生BERT 模型(DistilBERT 模型) 136

5.3 TinyBERT 模型简介 138

5.3.1 教师 学生架构 139

5.3.2 TinyBERT 模型的蒸馏 140

5.3.3 最终损失函数 145

5.3.4 训练学生BERT模型(TinyBERT 模型) 145

5.4 将知识从BERT 模型迁移到神经网络中 149

5.4.1 教师 学生架构 149

5.4.2 训练学生网络 151

5.4.3 数据增强方法 151

5.5 小结 153

5.6 习题 153

5.7 深入阅读 154

第三部分 BERT 模型的应用

第6章 用于文本摘要任务的BERTSUM 模型 156

6.1 文本摘要任务 156

6.1.1 提取式摘要任务 157

6.1.2 抽象式摘要任务 158

6.2 为文本摘要任务微调BERT模型 158

6.2.1 使用BERT模型执行提取式摘要任务 158

6.2.2 使用BERT 模型执行抽象式摘要任务 167

6.3 理解ROUGE 评估指标 169

6.3.1 理解ROUGE-N 指标 169

6.3.2 理解ROUGE-L 指标 171

6.4 BERTSUM 模型的性能 172

6.5 训练BERTSUM 模型 172

6.6 小结 174

6.7 习题 174

6.8 深入阅读 175

第7章 将BERT 模型应用于其他语言 176

7.1 理解多语言BERT 模型 177

7.2 M-BERT 模型的多语言表现 182

7.2.1 词汇重叠的影响 182

7.2.2 跨文本书写的通用性 183

7.2.3 跨类型特征的通用性 184

7.2.4 语言相似性的影响 184

7.2.5 语码混用和音译的影响 185

7.3 跨语言模型 187

7.3.1 预训练策略 188

7.3.2 预训练XLM模型 190

7.3.3 对XLM模型的评估 191

7.4 理解XLM-R模型 192

7.5 特定语言的BERT模型 194

7.5.1 法语的FlauBERT模型 194

7.5.2 西班牙语的BETO模型 196

7.5.3 荷兰语的BERTje模型 198

7.5.4 德语的BERT模型 199

7.5.5 汉语的BERT模型 200

7.5.6 日语的BERT模型 202

7.5.7 芬兰语的FinBERT模型 202

7.5.8 意大利语的UmBERTo模型 203

7.5.9 葡萄牙语的BERTimbau模型 204

7.5.10 俄语的RuBERT 模型 204

7.6 小结 206

7.7 习题 206

7.8 深入阅读 207

第8章 Sentence-BERT模型和特定领域的BERT 模型 208

8.1 用Sentence-BERT模型生成句子特征 208

8.1.1 计算句子特征 209

8.1.2 了解Sentence-BERT模型 211

8.2 sentence-transformers库 217

8.2.1 使用Sentence-BERT计算句子特征 217

8.2.2 计算句子的相似度 218

8.2.3 加载自定义模型 219

8.2.4 用Sentence-BERT模型寻找类似句子 220

8.3 通过知识蒸馏迁移多语言嵌入 221

8.3.1 教师 学生架构 223

8.3.2 使用多语言模型 224

8.4 特定领域的BERT模型:ClinicalBERT模型和BioBERT模型 225

8.4.1 ClinicalBERT模型 225

8.4.2 BioBERT模型 229

8.5 小结 232

8.6 习题 233

8.7 深入阅读 233

第9 章 VideoBERT模型和BART模型 234

9.1 VideoBERT模型学习语言及视频特征 235

9.1.1 预训练VideoBERT模型 235

9.1.2 数据源和预处理 239

9.1.3 VideoBERT模型的应用 240

9.2 了解BART模型 241

9.2.1 BART模型的架构 241

9.2.2 比较不同的预训练目标 245

9.2.3 使用BART 模型执行文本摘要任务 245

9.3 探讨BERT库 246

9.3.1 ktrain库 247

9.3.2 bert-as-service库 255

9.4 小结 258

9.5 习题 259

9.6 深入阅读 259

习题参考答案 260

媒体评论 在线试读部分章节 作者简介:苏达哈尔桑·拉维昌迪兰(Sudharsan Ravichandiran)

热爱开源社区的数据科学家,研究方向为深度学习和强化学习的实际应用,在自然语言处理和计算机视觉等领域都颇有建树,另著有《Python强化学习实战》。

作者简介:苏达哈尔桑·拉维昌迪兰(Sudharsan Ravichandiran)

热爱开源社区的数据科学家,研究方向为深度学习和强化学习的实际应用,在自然语言处理和计算机视觉等领域都颇有建树,另著有《Python强化学习实战》。......

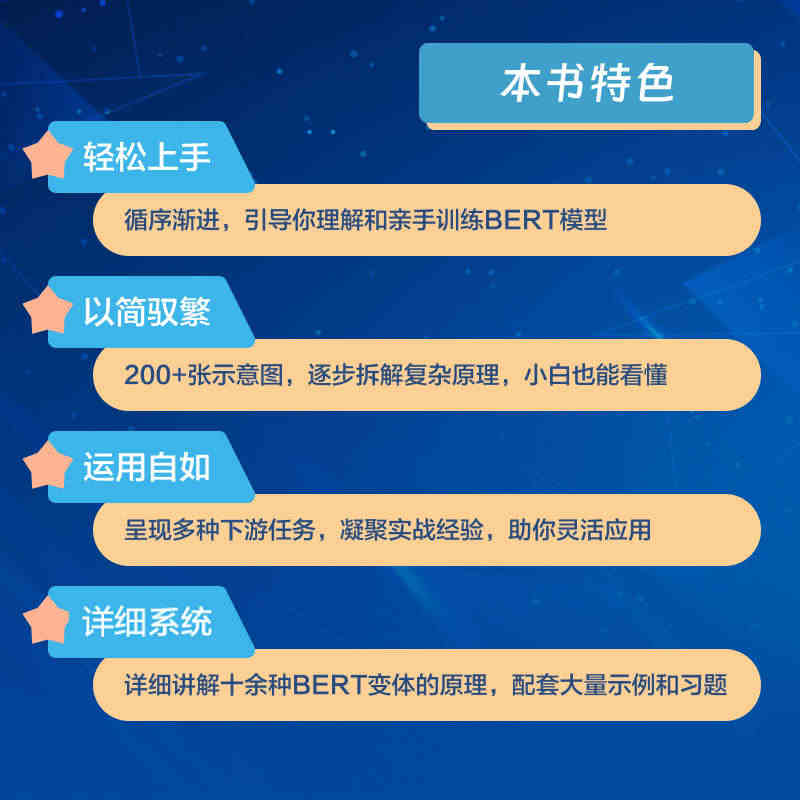

内容提要:本书聚焦谷歌公司开发的BERT自然语言处理模型,由浅入深地介绍了BERT的工作原理、BERT的各种变体及其应用。本书呈现了大量示意图、代码和实例,详细解析了如何训练BERT模型、如何使用BERT模型执行自然语言推理任务、文本摘要任务、问答任务、命名实体识别任务等各种下游任务,以及如何将BERT模型应用于多种语言。通读本书后,读者不仅能够全面了解有关BERT的各种概念、术语和原理,还能够使用BERT模型及其变体执行各种自然语言处理任务。

内容提要:本书聚焦谷歌公司开发的BERT自然语言处理模型,由浅入深地介绍了BERT的工作原理、BERT的各种变体及其应用。本书呈现了大量示意图、代码和实例,详细解析了如何训练BERT模型、如何使用BERT模型执行自然语言推理任务、文本摘要任务、问答任务、命名实体识别任务等各种下游任务,以及如何将BERT模型应用于多种语言。通读本书后,读者不仅能够全面了解有关BERT的各种概念、术语和原理,还能够使用BERT模型及其变体执行各种自然语言处理任务。......

目录:第 一部分 开始使用BERT

目录:第 一部分 开始使用BERT......

精 彩 页:

精 彩 页:......

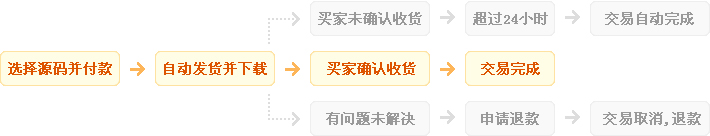

发货方式

自动:在特色服务中标有自动发货的商品,拍下后,源码类 软件类 商品会在订单详情页显示来自卖家的商品下载链接,点卡类 商品会在订单详情直接显示卡号密码。

手动:未标有自动发货的的商品,付款后,商品卖家会收到平台的手机短信、邮件提醒,卖家会尽快为您发货,如卖家长时间未发货,买家也可通过订单上的QQ或电话主动联系卖家。

退款说明

1、源码类:商品详情(含标题)与实际源码不一致的(例:描述PHP实际为ASP、描述的功能实际缺少、功能不能正常使用等)!有演示站时,与实际源码不一致的(但描述中有"不保证完全一样、可能有少许偏差"类似显著公告的除外);

2、营销推广类:未达到卖家描述标准的;

3、点卡软件类:所售点卡软件无法使用的;

3、发货:手动发货商品,在卖家未发货前就申请了退款的;

4、服务:卖家不提供承诺的售后服务的;(双方提前有商定和描述中有显著声明的除外)

5、其他:如商品或服务有质量方面的硬性常规问题的。未符合详情及卖家承诺的。

注:符合上述任一情况的,均支持退款,但卖家予以积极解决问题则除外。交易中的商品,卖家无法修改描述!

注意事项

1、在付款前,双方在QQ上所商定的内容,也是纠纷评判依据(商定与商品描述冲突时,以商定为准);

2、源码商品,同时有网站演示与商品详情图片演示,且网站演示与商品详情图片演示不一致的,默认按商品详情图片演示作为纠纷评判依据(卖家有特别声明或有额外商定的除外);

3、点卡软件商品,默认按商品详情作为纠纷评判依据(特别声明或有商定除外);

4、营销推广商品,默认按商品详情作为纠纷评判依据(特别声明或有商定除外);

5、在有"正当退款原因和依据"的前提下,写有"一旦售出,概不支持退款"等类似的声明,视为无效声明;

6、虽然交易产生纠纷的几率很小,卖家也肯定会给买家最完善的服务!但请买卖双方尽量保留如聊天记录这样的重要信息,以防产生纠纷时便于送码网快速介入处理。

送码声明

1、送码网作为第三方中介平台,依据双方交易合同(商品描述、交易前商定的内容)来保障交易的安全及买卖双方的权益;

2、非平台线上交易的项目,出现任何后果均与送码网无关;无论卖家以何理由要求线下交易的(如:要求买家支付宝转账付款的,微信转账付款的等),请联系管理举报,本平台将清退卖家处理。

¥215.00

¥215.00

正版 steam 原子之心 Atomic Heart 国区激活码 cd...

¥269.00

¥269.00

steam 英雄连3 国区激活码CDKEY PC游戏正版 Compan...

¥198.00

¥198.00

【骑砍中文站】PC 中文Steam 骑马与砍杀2 霸主 骑砍2 豪华版...

¥215.00

¥215.00

正版 steam 原子之心 Atomic Heart 国区激活码 cd...

¥734.95

¥734.95

M,日朋礼送男友老公创意实人用星人际机器蓝牙音箱走心情节生礼...

¥108.00

¥108.00

PC中文正版Steam 消逝的光芒2 消失的光芒2 Dying Lig...

¥199.00

¥199.00

Steam 女神异闻录5 皇家版 国区激活码CDKey秒发 Perso...

¥95.00

¥95.00

Steam怪物猎人崛起 曙光DLC 激活码cdkey 怪物猎人曙光 M...

¥119.00

¥119.00

steam 只狼 激活码CDKey 只狼影逝二度 Sekiro: Sh...

¥137.00

¥137.00

steam 女神异闻录5皇家版 国区激活码CDKey P5R 女神异闻...