分类

商品

- 商品

- 店铺

- 资讯

商品基本信息

商品名称:

机器学习:贝叶斯和优化方法(原书第2版)

作 者:

[希]西格尔斯·西奥多里蒂斯(Sergios Theodoridis)

市 场 价:

279.00元

ISBN 号:

9787111692577

页 数:

864

出 版 社:

机械工业出版社

目录

译者序

前言

致谢

作者简介

符号说明

第1章 引言1

1.1 历史背景1

1.2 人工智能与机器学习1

1.3 算法能学习数据中隐藏的东西3

1.4 机器学习典型应用4

1.4.1 语音识别4

1.4.2 计算机视觉4

1.4.3 多模态数据5

1.4.4 自然语言处理5

1.4.5 机器人5

1.4.6 自动驾驶5

1.4.7 未来的挑战5

1.5 机器学习的主要方向6

1.5.1 监督学习6

1.6 无监督和半监督学习8

1.7 本书结构和路线图9

参考文献11

第2章 概率和随机过程13

2.1 引言13

2.2 概率和随机变量13

2.2.1 概率13

2.2.2 离散随机变量14

2.2.3 连续随机变量16

2.2.4 均值和方差16

2.2.5 随机变量变换18

2.3 分布示例19

2.3.1 离散变量19

2.3.2 连续变量21

2.4 随机过程27

2.4.1 一阶和二阶统计量28

2.4.2 平稳性和遍历性29

2.4.3 功率谱密度31

2.4.4 自回归模型35

2.5 信息论38

2.5.1 离散随机变量38

2.5.2 连续随机变量41

2.6 随机收敛42

2.6.1 处处收敛43

2.6.2 几乎处处收敛43

2.6.3 均方意义下的收敛43

2.6.4 依概率收敛43

2.6.5 依分布收敛43

习题44

参考文献45

第3章 参数化建模学习:概念和方向46

3.1 引言46

3.2 参数估计:确定性观点46

3.3 线性回归49

3.4 分类52

3.4.1 生成和判别学习54

3.5 有偏估计与无偏估计55

3.5.1 选择有偏还是无偏估计56

3.6 克拉美-罗下界57

3.7 充分统计量60

3.8 正则化61

3.8.1 逆问题:病态和过拟合63

3.9 偏差-方差困境65

3.9.1 均方误差估计65

3.9.2 偏差-方差权衡66

3.10 最大似然法69

3.10.1 线性回归:非白高斯噪声实例71

3.11 贝叶斯推断71

3.11.1 最大后验概率估计方法74

3.12 维数灾难75

3.13 验证76

3.13.1 交叉验证77

3.14 期望损失函数和经验风险函数78

3.14.1 可学习性79

3.15 非参数建模和非参数估计79

习题80

参考文献83

第4章 均方误差线性估计85

4.1 引言85

4.2 均方误差线性估计:正规方程85

4.2.1 代价函数曲面86

4.3 几何观点:正交性条件87

4.4 扩展到复值变量89

4.4.1 宽线性复值估计90

4.4.2 复值变量优化:沃廷格微积分93

4.5 线性滤波94

4.6 均方误差线性滤波:频率域观点96

4.6.1 反卷积:图像去模糊96

4.7 一些典型应用98

4.7.1 干扰抵消98

4.7.2 系统辨识99

4.7.3 反卷积:信道均衡100

4.8 算法方面:莱文森算法和格-梯算法105

4.8.1 前向后向均方误差最优预测106

4.8.2 格-梯方案109

4.9 线性模型均方误差估计111

4.9.1 高斯-马尔可夫定理113

4.9.2 约束线性估计:波束成形实例115

4.10 时变统计:卡尔曼滤波118

习题123

参考文献125

第5章 随机梯度下降:LMS算法族127

5.1 引言127

5.2 最速下降法127

5.3 应用于均方误差代价函数130

5.3.1 时变步长135

5.3.2 复值情形135

5.4 随机逼近136

5.4.1 在均方误差线性估计中的应用138

5.5 最小均方自适应算法139

5.5.1 平稳环境中LMS算法的收敛和稳态性能140

5.5.2 累积损失上界144

5.6 仿射投影算法145

5.6.1 APA的几何解释147

5.6.2 正交投影148

5.6.3 归一化LMS算法149

5.7 复值情形150

5.7.1 宽线性LMS151

5.7.2 宽线性APA151

5.8 LMS同族算法152

5.8.1 符号误差LMS152

5.8.2 最小均四次方算法152

5.8.3 变换域LMS153

5.9 仿真示例155

5.10 自适应判决反馈均衡157

5.11 线性约束LMS159

5.12 非平稳环境中LMS算法的跟踪性能160

5.13 分布式学习:分布式LMS162

5.13.1 协同策略163

5.13.2 扩散LMS164

5.13.3 收敛和稳态性能:一些重点169

5.13.4 基于共识的分布式方法171

5.14 实例研究:目标定位172

5.15 一些结论:共识矩阵174

习题174

参考文献177

第6章 最小二乘算法族181

6.1 引言181

6.2 最小二乘线性回归:几何视角181

6.3 最小二乘估计的统计特性183

6.3.1 LS估计是无偏估计183

6.3.2 LS估计的协方差矩阵183

6.3.3 白噪声下LS估计是最优线性无偏估计184

6.3.4 高斯白噪声下LS估计达到克拉美-罗界185

6.3.5 LS估计的渐近分布185

6.4 正交化输入矩阵的列空间:SVD方法186

6.4.1 伪逆矩阵和SVD187

6.5 岭回归:几何观点189

6.5.1 主成分回归190

6.6 递归最小二乘算法191

6.6.1 时间迭代计算192

6.6.2 参数的时间更新192

6.7 牛顿迭代极小化方法194

6.7.1 RLS和牛顿方法195

6.8 RLS的稳态性能196

6.9 复值数据:宽线性RLS198

6.10 LS方法的计算199

6.10.1 乔列斯基分解199

6.10.2 QR分解199

6.10.3 快速RLS版本200

6.11 坐标下降法和循环坐标下降法201

6.12 仿真示例202

6.13 总体最小二乘法205

6.13.1 总体最小二乘法的几何解释208

习题210

参考文献212

第7章 分类:经典方法导览215

7.1 引言215

7.2 贝叶斯分类215

7.2.1 贝叶斯分类器最小化分类误差216

7.2.2 平均风险217

7.3 决策(超)曲面219

7.3.1 高斯分布实例220

7.4 朴素贝叶斯分类器224

7.5 最近邻法则225

7.6 对数几率回归226

7.7 费舍尔线性判别230

7.7.1 散布矩阵230

7.7.2 费舍尔判别:两类情况232

7.7.3 费舍尔判别:多类情况234

7.8 分类树235

7.9 分类器组合238

7.9.1 无免费午餐原理238

7.9.2 一些实验比较239

7.9.3 分类器组合方案239

7.10 提升方法241

7.10.1 AdaBoost算法241

7.10.2 对数损失函数244

7.11 提升树246

习题247

参考文献250

第8章 参数学习:凸分析方法252

8.1 引言252

8.2 凸集和凸函数252

8.2.1 凸集252

8.2.2 凸函数254

8.3 凸集投影法256

8.3.1 投影特性258

8.4 凸集投影基本定理261

8.5 并行POCS263

8.6 从凸集到参数估计和机器学习264

8.6.1 回归264

8.6.2 分类266

8.7 无穷多封闭凸集:在线学习实例267

8.7.1 APSM的收敛性269

8.8 约束学习272

8.9 分布式APSM273

8.10 优化非光滑凸代价函数275

8.10.1 次梯度和次微分275

8.10.2 最小化非光滑连续凸损失函数:批量学习实例277

8.10.3 凸优化在线学习281

8.11 悔过分析284

8.11.1 次梯度算法的悔过分析285

8.12 在线学习和大数据应用:讨论286

8.12.1 近似、估计和优化误差287

8.12.2 批处理与在线学习288

8.13 近端算子290

8.13.1 近端算子的性质293

8.13.2 近端最小化293

8.14 近端分裂优化方法295

8.14.1 近端前向-后向分裂算子297

8.14.2 交替方向乘子法297

8.14.3 镜像下降算法298

8.15 分布式优化:一些要点299

习题300

参考文献303

第9章 稀疏感知学习:概念和理论基础307

9.1 引言307

9.2 寻找范数307

9.3 最小绝对收缩和选择算子309

9.4 稀疏信号表示313

9.5 寻找最稀疏解315

9.5.1 2范数极小值316

9.5.2 0范数极小值317

9.5.3 1范数极小值317

9.5.4 1范数极小值的性质318

9.5.5 几何解释319

9.6 0极小值的唯一性321

9.6.1 互相干322

9.7 0和1极小值等价的充分条件324

9.7.1 自相干数隐含的条件324

9.7.2 约束等距性324

9.8 基于噪声测量的鲁棒稀疏信号恢复327

9.9 压缩感知:随机性的荣光328

9.9.1 压缩感知328

9.9.2 降维和稳定嵌入329

9.9.3 欠奈奎斯特采样:模拟信息转换330

9.10 实例研究:图像降噪333

习题335

参考文献337

第10章 稀疏感知学习:算法和应用341

10.1 引言341

10.2 稀疏提升算法341

10.2.1 贪心算法341

10.2.2 迭代收缩/阈值算法345

10.2.3 关于算法选择的一些实用提示351

10.3 稀疏感知方法的变化354

10.4 在线稀疏提升算法360

10.4.1 LASSO:渐近性能361

10.4.2 自适应加权范数LASSO362

10.4.3 自适应CoSaMP算法363

10.4.4 稀疏自适应投影次梯度方法364

10.5 稀疏分析学习模型368

10.5.1 相干字典表示的稀疏信号的压缩感知370

10.5.2 共稀疏性371

10.6 实例研究:时频分析373

10.6.1 伽柏变换和框架373

10.6.2 时频分辨率374

10.6.3 伽柏框架374

10.6.4 蝙蝠发出的回声定位信号的时频分析375

习题377

参考文献379

第11章 再生核希尔伯特空间中的学习383

11.1 引言383

11.2 广义线性模型383

11.3 沃尔泰拉模型、维纳模型和哈默斯坦模型384

11.4 科弗定理:线性二分空间的容量386

11.5 再生核希尔伯特空间388

11.5.1 一些性质和理论要点389

11.5.2 核函数示例390

11.6 表示定理395

11.6.1 半参表示定理396

11.6.2 非参建模:讨论397

11.7 核岭回归397

11.8 支持向量回归399

11.8.1 线性不敏感最优回归400

11.9 核岭回归回顾405

11.10 最优边距分类:支持向量机406

11.10.1 线性可分类别:最大边距分类器407

11.10.2 不可分类别410

11.10.3 SVM的性能及其应用414

11.10.4 超参数的选择414

11.10.5 推广为多类分类器414

11.11 计算方面的考虑415

11.12 随机傅里叶特征416

11.12.1 RKHS中的在线和分布式学习418

11.13 多核学习418

11.14 非参稀疏感知学习:可加模型420

11.15 实例研究:作者身份认证422

习题424

参考文献426

第12章 贝叶斯学习:推断和EM算法431

12.1 引言431

12.2 回归:贝叶斯观点431

12.2.1 极大似然估计432

12.2.2 MAP估计432

12.2.3 贝叶斯方法433

12.3 证据函数和奥卡姆剃刀法则438

12.3.1 拉普拉斯近似和证据函数440

12.4 潜变量和EM算法443

12.4.1 最大期望算法444

12.5 线性回归和EM算法445

12.6 高斯混合模型447

12.6.1 高斯混合模型与聚类451

12.7 EM算法:下界最大化视角453

12.8 指数族概率分布456

12.8.1 指数族和最大熵法460

12.9 学习模型组合:概率观点461

12.9.1 混合线性回归模型461

12.9.2 混合对率回归模型465

习题466

参考文献469

第13章 贝叶斯学习:近似推断和非参模型471

13.1 引言471

13.2 变分近似贝叶斯学习471

13.2.1 平均场近似472

13.2.2 指数族概率分布实例475

13.3 线性回归的变分贝叶斯方法476

13.3.1 下界的计算480

13.4 变分贝叶斯方法应用于高斯混合模型481

13.5 当贝叶斯推断遇到稀疏性484

13.6 稀疏贝叶斯学习486

13.6.1 钉板方法488

13.7 关联向量机框架489

13.7.1 用对率回归模型进行分类489

13.8 凸对偶与变分界492

13.9 稀疏感知回归:变分界贝叶斯方法495

13.9.1 稀疏感知学习:一些结论498

13.10 期望传播499

13.10.1 最小化KL散度500

13.10.2 期望传播算法500

13.11 非参贝叶斯建模502

13.11.1 中国餐馆过程503

13.11.2 狄利克雷过程503

13.11.3 DP的截棍构造507

13.11.4 狄利克雷过程混合建模508

13.11.5 推理509

13.11.6 印度自助餐过程511

13.12 高斯过程517

13.12.1 协方差函数与核518

13.12.2 回归519

13.12.3 分类521

13.13 实例研究:高光谱图像分离522

13.13.1 层级贝叶斯建模523

13.13.2 实验结果524

习题525

参考文献528

第14章 蒙特卡罗方法532

14.1 引言532

14.2 蒙特卡罗方法:主要思想532

14.2.1 随机数发生533

14.3 基于函数变换的随机抽样534

14.4 拒绝抽样538

14.5 重要性抽样540

14.6 蒙特卡罗方法与EM算法542

14.7 马尔可夫链蒙特卡罗法542

14.7.1 遍历马尔可夫链544

14.8 梅特罗波利斯方法548

14.8.1 收敛问题550

14.9 吉布斯抽样552

14.10 寻找更有效的方法:一些讨论554

14.10.1 变分推断或蒙特卡罗方法555

14.11 实例研究:变点检测555

习题557

参考文献559

第15章 概率图模型:第一部分561

15.1 引言561

15.2 图模型的必要性561

15.3 贝叶斯网络与马尔可夫条件563

15.3.1 图:基本定义564

15.3.2 因果关系的一些提示566

15.3.3 d分离568

15.3.4 S形贝叶斯网络570

15.3.5 线性高斯模型571

15.3.6 多因网络572

15.3.7 I映射、可靠性、忠实性和完备性572

15.4 无向图模型573

15.4.1 马尔可夫随机场中的独立性和I映射574

15.4.2 伊辛模型及其变体575

15.4.3 条件随机场577

15.5 因子图578

15.5.1 纠错码的图模型579

15.6 有向图端正化580

15.7 精确推理法:消息传递算法581

15.7.1 链精确推理581

15.7.2 树精确推理584

15.7.3 和积算法585

15.7.4 最大积与最大和算法589

习题594

参考文献595

第16章 概率图模型:第二部分597

16.1 引言597

16.2 三角剖分图与联合树597

16.2.1 构造连接树599

16.2.2 联合树中的消息传递601

16.3 近似推理方法603

16.3.1 变分法:局部近似603

16.3.2 分块变分近似法607

16.3.3 环路信念传播609

16.4 动态图模型612

16.5 隐马尔可夫模型613

16.5.1 推理615

16.5.2 HMM参数学习619

16.5.3 判别学习621

16.6 超越HMM:讨论622

16.6.1 因子隐马尔可夫模型622

16.6.2 时变动态贝叶斯网络624

16.7 图模型学习625

16.7.1 参数估计625

16.7.2 结构学习627

习题628

参考文献629

第17章 粒子滤波633

17.1 引言633

17.2 顺序重要性抽样633

17.2.1 重要性抽样回顾633

17.2.2 重抽样634

17.2.3 顺序抽样636

17.3 卡尔曼和粒子滤波638

17.3.1 卡尔曼滤波:贝叶斯观点639

17.4 粒子滤波640

17.4.1 退化645

17.4.2 通用粒子滤波645

17.4.3 辅助粒子滤波647

习题652

参考文献654

第18章 神经网络和深度学习656

18.1 引言656

18.2 感知机657

18.3 前馈多层神经网络660

18.3.1 全连接网络663

18.4 逆传播算法664

18.4.1 代价函数的非凸性665

18.4.2 梯度下降逆传播方法666

18.4.3 基本梯度下降法的变体672

18.4.4 超越梯度下降原理679

18.5 代价函数的选择680

18.6 梯度消失和梯度爆炸682

18.6.1 整流线性单元683

18.7 网络正则化684

18.7.1 dropout686

18.8 设计深度神经网络:总结688

18.9 前馈神经网络的普遍近似特性689

18.10 神经网络:贝叶斯风格690

18.11 浅层结构与深层结构691

18.11.1 深层结构的力量691

18.12 卷积神经网络695

18.12.1 对卷积的需求695

18.12.2 体上的卷积701

18.12.3 全卷积结构704

18.12.4 CNN:尾声706

18.13 递归神经网络709

18.13.1 时间逆传播710

18.13.2 注意力和记忆713

18.14 对抗示例715

18.14.1 对抗训练716

18.15 深度生成模型717

18.15.1 受限玻尔兹曼机718

18.15.2 预训练深度前馈网络719

18.15.3 深度信念网络720

18.15.4 自编码器722

18.15.5 生成对抗网络723

18.15.6 变分自编码器729

18.16 胶囊网络731

18.16.1 训练734

18.17 深度神经网络:最后的话735

18.17.1 迁移学习735

18.17.2 多任务学习736

18.17.3 几何深度学习737

18.17.4 开放问题738

18.18 实例研究:神经网络机器翻译738

习题743

参考文献746

第19章 降维与潜变量模型755

19.1 引言755

19.2 本征维数755

19.3 主成分分析756

19.3.1 PCA、SVD以及低秩矩阵分解757

19.3.2 最小误差解释758

19.3.3 PCA和信息检索759

19.3.4 PCA和特征生成的正交性759

19.3.5 潜变量760

19.4 典型相关分析764

19.4.1 CCA同类方法767

19.5 独立成分分析768

19.5.1 ICA和高斯函数769

19.5.2 ICA和高阶累积量769

19.5.3 非高斯性和独立成分771

19.5.4 基于互信息的ICA771

19.5.5 其他ICA方法774

19.5.6 鸡尾酒会问题774

19.6 字典学习:kSVD算法777

19.6.1 为什么命名为kSVD779

19.6.2 字典学习和字典可辨识性779

19.7 非负矩阵分解782

19.8 低维模型学习:概率视角782

19.8.1 因子分析783

19.8.2 概率PCA784

19.8.3 混合因子分析:压缩感知的贝叶斯观点786

19.9 非线性降维789

19.9.1 核PCA方法789

19.9.2 基于图的方法790

19.10 低秩矩阵分解:一种稀疏建模的方法797

19.10.1 矩阵补全797

19.10.2 鲁棒PCA799

19.10.3 矩阵补全和鲁棒PCA的应用800

19.11 实例研究:fMRI数据分析802

习题804

参考文献806

索引812

在线章节

第8章附录

第10章附录

第12章附录

附录A

附录B

附录C

请访问原书配套网站下载,详见前言中的说明。——编辑注

内容简介

本书对所有重要的机器学习方法和新近研究趋势进行了深入探索,新版重写了关于神经网络和深度学习的章节,并扩展了关于贝叶斯学习的内容。书中首先讨论基础知识,包括均方、zui小二乘和zui大似然方法,以及岭回归、贝叶斯决策理论分类、逻辑回归和决策树。然后介绍较新的技术,包括稀疏建模方法、再生核希尔伯特空间和支持向量机中的学习、关注EM算法的贝叶斯推理及其变分近似推理、蒙特卡罗方法、关注贝叶斯网络的概率图模型、隐马尔可夫模型和粒子滤波。此外,书中还讨论了降维、隐变量建模、统计参数估计、维纳和卡尔曼滤波、凸优化等技术。本书适合该领域的科研人员和工程师阅读,也适合学习模式识别、统计/自适应信号处理和深度学习等课程的学生参考。

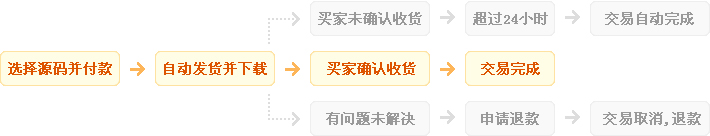

发货方式

自动:在特色服务中标有自动发货的商品,拍下后,源码类 软件类 商品会在订单详情页显示来自卖家的商品下载链接,点卡类 商品会在订单详情直接显示卡号密码。

手动:未标有自动发货的的商品,付款后,商品卖家会收到平台的手机短信、邮件提醒,卖家会尽快为您发货,如卖家长时间未发货,买家也可通过订单上的QQ或电话主动联系卖家。

退款说明

1、源码类:商品详情(含标题)与实际源码不一致的(例:描述PHP实际为ASP、描述的功能实际缺少、功能不能正常使用等)!有演示站时,与实际源码不一致的(但描述中有"不保证完全一样、可能有少许偏差"类似显著公告的除外);

2、营销推广类:未达到卖家描述标准的;

3、点卡软件类:所售点卡软件无法使用的;

3、发货:手动发货商品,在卖家未发货前就申请了退款的;

4、服务:卖家不提供承诺的售后服务的;(双方提前有商定和描述中有显著声明的除外)

5、其他:如商品或服务有质量方面的硬性常规问题的。未符合详情及卖家承诺的。

注:符合上述任一情况的,均支持退款,但卖家予以积极解决问题则除外。交易中的商品,卖家无法修改描述!

注意事项

1、在付款前,双方在QQ上所商定的内容,也是纠纷评判依据(商定与商品描述冲突时,以商定为准);

2、源码商品,同时有网站演示与商品详情图片演示,且网站演示与商品详情图片演示不一致的,默认按商品详情图片演示作为纠纷评判依据(卖家有特别声明或有额外商定的除外);

3、点卡软件商品,默认按商品详情作为纠纷评判依据(特别声明或有商定除外);

4、营销推广商品,默认按商品详情作为纠纷评判依据(特别声明或有商定除外);

5、在有"正当退款原因和依据"的前提下,写有"一旦售出,概不支持退款"等类似的声明,视为无效声明;

6、虽然交易产生纠纷的几率很小,卖家也肯定会给买家最完善的服务!但请买卖双方尽量保留如聊天记录这样的重要信息,以防产生纠纷时便于送码网快速介入处理。

送码声明

1、送码网作为第三方中介平台,依据双方交易合同(商品描述、交易前商定的内容)来保障交易的安全及买卖双方的权益;

2、非平台线上交易的项目,出现任何后果均与送码网无关;无论卖家以何理由要求线下交易的(如:要求买家支付宝转账付款的,微信转账付款的等),请联系管理举报,本平台将清退卖家处理。

¥215.00

¥215.00

正版 steam 原子之心 Atomic Heart 国区激活码 cd...

¥269.00

¥269.00

steam 英雄连3 国区激活码CDKEY PC游戏正版 Compan...

¥198.00

¥198.00

【骑砍中文站】PC 中文Steam 骑马与砍杀2 霸主 骑砍2 豪华版...

¥215.00

¥215.00

正版 steam 原子之心 Atomic Heart 国区激活码 cd...

¥734.95

¥734.95

M,日朋礼送男友老公创意实人用星人际机器蓝牙音箱走心情节生礼...

¥108.00

¥108.00

PC中文正版Steam 消逝的光芒2 消失的光芒2 Dying Lig...

¥199.00

¥199.00

Steam 女神异闻录5 皇家版 国区激活码CDKey秒发 Perso...

¥95.00

¥95.00

Steam怪物猎人崛起 曙光DLC 激活码cdkey 怪物猎人曙光 M...

¥119.00

¥119.00

steam 只狼 激活码CDKey 只狼影逝二度 Sekiro: Sh...

¥137.00

¥137.00

steam 女神异闻录5皇家版 国区激活码CDKey P5R 女神异闻...