分类

商品

- 商品

- 店铺

- 资讯

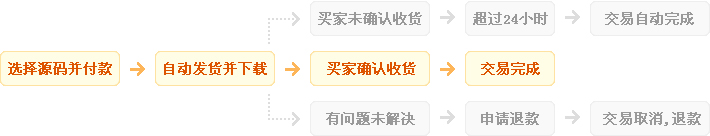

发货方式

自动:在特色服务中标有自动发货的商品,拍下后,源码类 软件类 商品会在订单详情页显示来自卖家的商品下载链接,点卡类 商品会在订单详情直接显示卡号密码。

手动:未标有自动发货的的商品,付款后,商品卖家会收到平台的手机短信、邮件提醒,卖家会尽快为您发货,如卖家长时间未发货,买家也可通过订单上的QQ或电话主动联系卖家。

退款说明

1、源码类:商品详情(含标题)与实际源码不一致的(例:描述PHP实际为ASP、描述的功能实际缺少、功能不能正常使用等)!有演示站时,与实际源码不一致的(但描述中有"不保证完全一样、可能有少许偏差"类似显著公告的除外);

2、营销推广类:未达到卖家描述标准的;

3、点卡软件类:所售点卡软件无法使用的;

3、发货:手动发货商品,在卖家未发货前就申请了退款的;

4、服务:卖家不提供承诺的售后服务的;(双方提前有商定和描述中有显著声明的除外)

5、其他:如商品或服务有质量方面的硬性常规问题的。未符合详情及卖家承诺的。

注:符合上述任一情况的,均支持退款,但卖家予以积极解决问题则除外。交易中的商品,卖家无法修改描述!

注意事项

1、在付款前,双方在QQ上所商定的内容,也是纠纷评判依据(商定与商品描述冲突时,以商定为准);

2、源码商品,同时有网站演示与商品详情图片演示,且网站演示与商品详情图片演示不一致的,默认按商品详情图片演示作为纠纷评判依据(卖家有特别声明或有额外商定的除外);

3、点卡软件商品,默认按商品详情作为纠纷评判依据(特别声明或有商定除外);

4、营销推广商品,默认按商品详情作为纠纷评判依据(特别声明或有商定除外);

5、在有"正当退款原因和依据"的前提下,写有"一旦售出,概不支持退款"等类似的声明,视为无效声明;

6、虽然交易产生纠纷的几率很小,卖家也肯定会给买家最完善的服务!但请买卖双方尽量保留如聊天记录这样的重要信息,以防产生纠纷时便于送码网快速介入处理。

送码声明

1、送码网作为第三方中介平台,依据双方交易合同(商品描述、交易前商定的内容)来保障交易的安全及买卖双方的权益;

2、非平台线上交易的项目,出现任何后果均与送码网无关;无论卖家以何理由要求线下交易的(如:要求买家支付宝转账付款的,微信转账付款的等),请联系管理举报,本平台将清退卖家处理。

¥215.00

¥215.00

正版 steam 原子之心 Atomic Heart 国区激活码 cd...

¥269.00

¥269.00

steam 英雄连3 国区激活码CDKEY PC游戏正版 Compan...

¥198.00

¥198.00

【骑砍中文站】PC 中文Steam 骑马与砍杀2 霸主 骑砍2 豪华版...

¥215.00

¥215.00

正版 steam 原子之心 Atomic Heart 国区激活码 cd...

¥734.95

¥734.95

M,日朋礼送男友老公创意实人用星人际机器蓝牙音箱走心情节生礼...

¥108.00

¥108.00

PC中文正版Steam 消逝的光芒2 消失的光芒2 Dying Lig...

¥199.00

¥199.00

Steam 女神异闻录5 皇家版 国区激活码CDKey秒发 Perso...

¥95.00

¥95.00

Steam怪物猎人崛起 曙光DLC 激活码cdkey 怪物猎人曙光 M...

¥119.00

¥119.00

steam 只狼 激活码CDKey 只狼影逝二度 Sekiro: Sh...

¥137.00

¥137.00

steam 女神异闻录5皇家版 国区激活码CDKey P5R 女神异闻...

¥2.9

¥2.9

PC中文正版 steam平台 国区 游戏 工业区 INDUSTRIA ...

¥59.9

¥59.9

贾东普钓鱼小药黑坑野钓食会添加剂鲫鱼鲤鱼草鱼青鱼果酸饵料诱鱼...

¥328.2

¥328.2

编程机器人arduino智能小车入门学习套件 UNO循迹避障DIY开发...

¥70.00

¥70.00

腾讯斗战神点卡 斗战神金子 斗战神70元7000金子点卡 自动充值...

¥127.00

¥127.00

天龙八部 共5册 金庸原著正版 朗声新修版金庸武侠小说作品集 新定本精...

¥174.00

¥174.00

海外直订Human/Machine: The Future of Ou...

¥29.00

¥29.00

PC中文 steam正版 死亡循环 DEATHLOOP 国区cdkey...

¥59.00

¥59.00

蕉下防晒口罩女防紫外线全脸立体护眼角护颈面罩冰丝夏季薄款官网...

¥898.00

¥898.00

火火兔智能机器人儿童早教机婴幼儿益智学习机3岁平板阅读机器人...

¥17.00

¥17.00

Steam PC中文正版 文明6 激活码key Civilizatio...